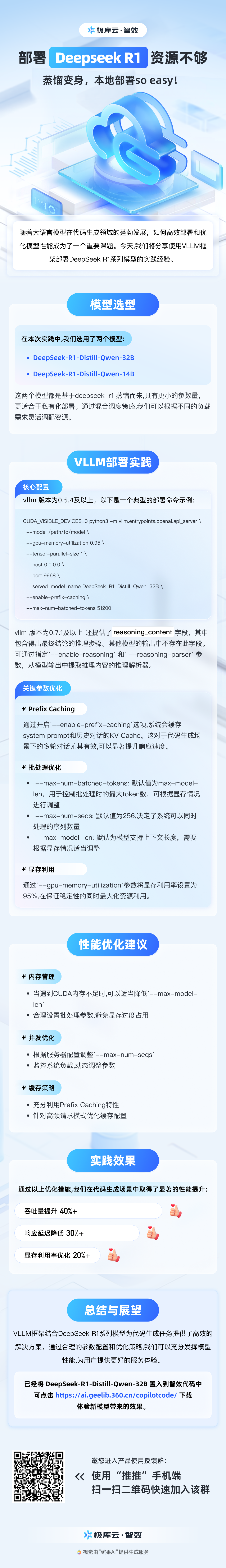

本地部署DeepSeek-R1模型的方法

随着大语言模型在代码生成领域的蓬勃发展,如何高效部署和优化模型性能成为了一个重要课题。今天,我们将分享使用VLLM框架部署DeepSeek-R1系列模型的实践经验。

模型选型

在本次实践中,我们选用了两个模型:

- DeepSeek-R1-Distill-Qwen-32B

- DeepSeek-R1-Distill-Qwen-14B这两个模型都是基于DeepSeek-R1 蒸馏而来,具有更小的参数量,更适合于私有化部署。通过混合调度策略,我们可以根据不同的负载需求灵活调配资源。

VLLM部署实践

核心配置

vllm 版本为0.5.4及以上,以下是一个典型的部署命令示例:

CUDA_VISIBLE_DEVICES=0 python3 -m vllm.entrypoints.openai.api_server \

--model /path/to/model \

--gpu-memory-utilization 0.95 \

--tensor-parallel-size 1 \

--host 0.0.0.0 \

--port 9968 \

--served-model-name DeepSeek-R1-Distill-Qwen-32B \

--enable-prefix-caching \

--max-num-batched-tokens 51200vllm 版本为0.7.1及以上 还提供了reasoning_content 字段,其中包含得出最终结论的推理步骤。其他模型的输出中不存在此字段。

可通过指定--enable-reasoning 和--reasoning-parser 参数,从模型输出中提取推理内容的推理解析器。

关键参数优化

1. Prefix Caching

通过开启--enable-prefix-caching选项,系统会缓存system prompt和历史对话的KV Cache 。这对于代码生成场景下的多轮对话尤其有效,可以显著提升响应速度。

2. 批处理优化

--max-num-batched-tokens: 默认值为max-model-len,用于控制批处理时的最大token数,可根据显存情况进行调整--max-num-seqs: 默认值为256,决定了系统可以同时处理的序列数量--max-model-len: 默认为模型支持上下文长度,需要根据显存情况适当调整

3. 显存利用

通过--gpu-memory-utilization参数将显存利用率设置为95%,在保证稳定性的同时最大化资源利用。

性能优化建议

1. 内存管理

- 当遇到CUDA内存不足时,可以适当降低

--max-model-len - 合理设置批处理参数,避免显存过度占用

2. 并发优化

- 根据服务器配置调整

--max-num-seqs - 监控系统负载,动态调整参数

3. 缓存策略

- 充分利用

Prefix Caching特性 - 针对高频请求模式优化缓存配置

实践效果

通过以上优化措施,我们在代码生成场景中取得了显著的性能提升:

- 响应延迟降低30%+

- 吞吐量提升40%+

- 显存利用率优化20%+

总结与展望

VLLM框架结合DeepSeek-R1系列模型为代码生成任务提供了高效的解决方案。通过合理的参数配置和优化策略,我们可以充分发挥模型性能,为用户提供更好的服务体验。

已经将 DeepSeek-R1-Distill-Qwen-32B 置入到智效代码中,可点击 https://ai.geelib.360.cn/copilotcodedocs/ 下载,体验新模型带来的效果。

一图览全部